2025年のAIは、驚きに満ちた一年となるでしょう。実際、新年が始まってわずか1カ月の間に、DeepSeekの登場やStargateプロジェクトによるAI主権競争の加速がすでに見られています。こうした不確実性の中で、唯一確実に言えることは、これらの出来事でさえも、6月には遠い記憶のように感じられるかもしれません。

国家、大手テクノロジー企業、そしてVC資金を受けたスタートアップが、AGI(汎用人工知能)に向けて競争を繰り広げています。こうした大きな言葉がメディアで語られ、耳にするたびにふと思うことがあります。果たして、この技術によって人生が変わる何十億もの人々の声は、どこにあるのでしょうか?AIはますます私たちの日常に深く組み込まれ、その統合は今後さらに進んでいくでしょう。この技術革新は、単なる道具の進化ではなく、私たちの生き方そのものを根本的に変えていくものです。果たして、私たちの大多数は、一部の限られた人々によって形作られる技術的未来をただ受け入れるしかないのでしょうか?そして、その決定を下す人々が、人類の最善の利益のために行動すると、私たちは信じることができるのでしょうか?

提唱されるAIの未来像は、私たちの想像力を大いに広げます。単調な仕事からの解放、創造性と生産性の飛躍的な向上、さらには宇宙探査やトランスヒューマニズム的進化まで、その可能性は多岐にわたります。しかし、あらゆる進歩にはトレードオフがあるにもかかわらず、多くの人々は日々の生活に追われ、この未来が仮に実現可能だとしても、自分たちの価値観や望む生き方と本当に一致するのかを考える余裕がありません。

この視点から見ると、AI倫理学者は、すでに部分的に現実でありながらも完全には実現していないこの未来と、私たちに代わって取り組む人々だと考えられます。しかし、彼らでさえも、壮大な物語や急激な変化の波に対して無力感を抱いています。倫理的な懸念を訴える人々は、ますます失望を強いられているのが現状です。AI分野の流動性は極端であり、トランプ政権がバイデン政権のAIに関する大統領令をあっという間に撤回したことが、その不安定さを如実に示しています。AI倫理の専門家たちは、絶えず変化する指針の中で翻弄され、燃え尽き症候群に苦しんでいます。さらに、OpenAIのような主要プレイヤーが倫理について語ったとしても、その言葉は空虚に響き、実質的な倫理的監視への希望を持ち続けることがますます難しくなっています。

私たちは今、AI倫理のどこに立っているのか?

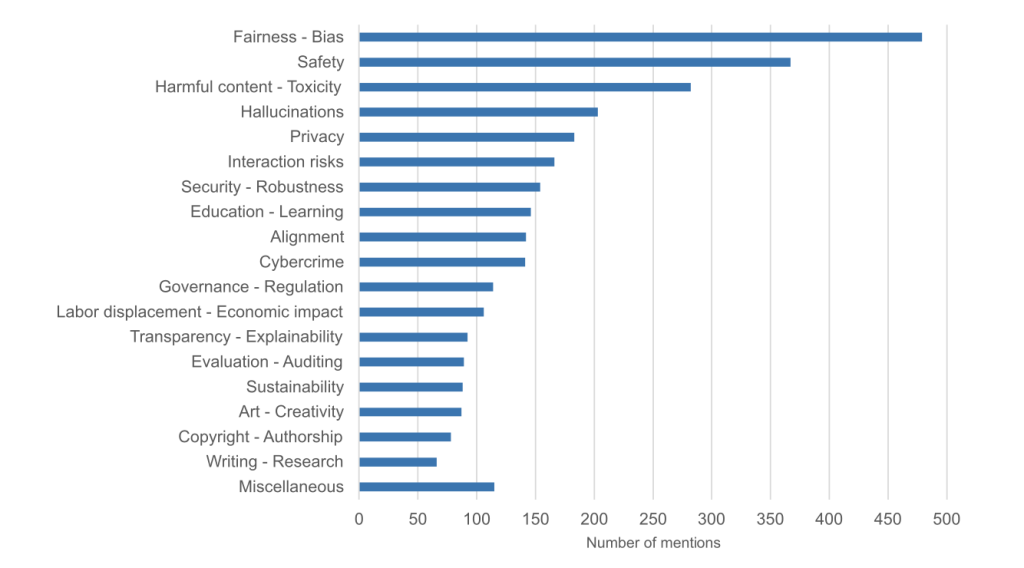

この分野には多様な声や活動家が存在するものの、主流のAI倫理の議論は、公正性、バイアス、安全性の問題に集中してきました。特に、トップダウンの解決策が重視され、企業に対する規制の策定や、一般市民の意識向上が中心となっています。このアプローチについては、ティロ・ハーゲンドルフ (Thilo Hagendorff) の2024年の論文でも詳しく論じられています。

当初、AI倫理は倫理原則のリストを作成することに重点を置いていましたが、その後、これらの原則を実装する方向へとシフトしました。全体として、AI倫理の焦点は、技術的な解決策によって対処可能な問題、つまりAIシステムの説明可能性、公平性、プライバシー、安全性の確保といった課題に限定されてきたと言えます。これは主に、これらの問題が開発者によって直接対処できるものであるためです。

この技術的な焦点は実用的ではあるものの、AI倫理が本来持つ重要な役割の一つです。つまり、より広範な社会的な害を特定し、テクノロジー業界の外にいる人々への影響を考慮するという視点から乖離する結果を招いています。解決可能な技術的課題を優先することは理解できますが、このアプローチは、一種の技術的解決主義(technological solutionism)を反映していると言えるでしょう。

しかし、AIがさまざまな分野で人間の専門知識を置き換えたり強化したりするという約束を果たすのであれば、その適応力の高さゆえに、関与する領域の倫理的・政治的な側面とも必然的に深く絡み合うことになります。AI倫理における多くの重要な課題は、技術的な修正や単なるコンプライアンスのチェックリストでは解決できません。例えば、社会的結束、民主的価値観、公民連携、環境への影響といった問題は、技術的手法だけでは十分に対処することができません。それにもかかわらず、こうした本質的な問題は、現在のAI倫理の議論において十分な注目を受けていないように思われます。

AI分野がますます技術的になるにつれ、暗黙のうちに「専門家のみがAIガバナンスに実質的に関与できる」という障壁が生まれています。一般の人々は傍観者の立場に追いやられ、AIに関する教育資料やイベントが提供される程度にとどまり、実際の意思決定プロセスからは除外されたままです。

三つの層

最近、倫理学の博士号を持つ友人がこう言いました。「最近の ‘AI倫理’ に関する議論を聞いていると、時々混乱するんだ。『ここに倫理はあるのか?』と考えてしまうよ。」確かに、現在のAI倫理の議論は、伝統的な倫理学とはほとんど似ていないように思えます。本来、倫理学は「良い人生とは何か」「人間はどのようにして幸福に生きることができるのか」といった根源的な問いを探求するものです。しかし、現代のAI倫理の議論は、主に技術的な修正や規制の問題に集中しているため、この断絶が生じています。このギャップは時に誤解を生み、同じ目標に向かっているはずの人々が、まるで異なる言語を話しているかのように感じられることもあります。

AI倫理学者1:「AIリテラシーを向上させるために、教育への投資をさらに増やすべきだと思います。若い学生がテクノロジーについて批判的に考える力を養うことは、非常に重要です。」

AI倫理学者2: 「はい、教育の重要性には同意します。しかし、それには時間がかかるうえ、確実に効果が出るとは限りません。それよりも、アルゴリズムのバイアスを是正するための規制に注力すべきではないでしょうか。その方が、より即時的な影響を与えられるはずです。」

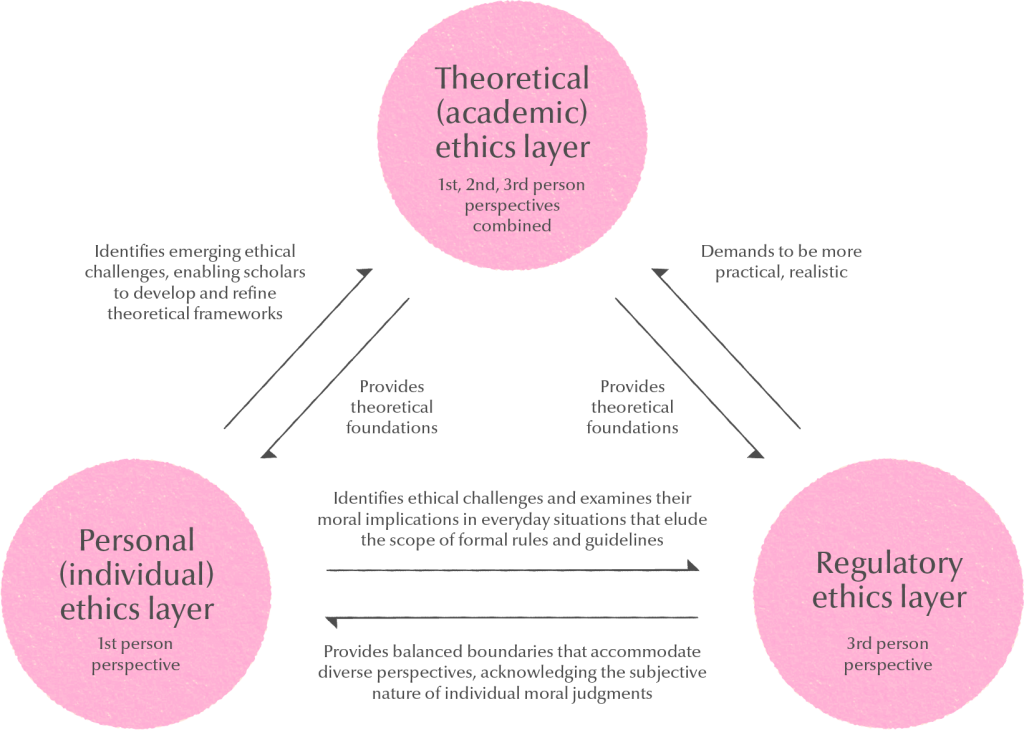

この文脈において、モク・グァンス(Gwang-Soo Mok)教授のフレームワークは、AI倫理をより包括的に理解するための適切な視点を提供しています。彼は、AI倫理が 規制的、個人的、理論的 という3つの補完的な層で機能すると提唱しています。(これまで議論してきた技術的対策や規制は、規制層に分類されます。)

特に重要なのが「個人層」です。これは、AI倫理の議論の中でほとんど取り上げられてこなかった要素であり、この層には、開発者(AI開発に関わるすべての実務者を含む)とユーザーの二つのグループが含まれます。開発者向けの取り組みとしては、組み込み倫理(embedded ethics)プログラムのようなイニシアチブが一定の注目を集めていますが、ユーザーの視点に関する議論はほとんど進んでいません。しかし、このユーザー側の視点も非常に重要です。技術を批判的に捉え、内面化された倫理的意識に基づいて適切に利用できるようにすることが求められます。ハーゲンドルフによる「信頼できるAI(trustworthy AI)」への批判は、この点をよく示しています。彼は、AIシステムへの盲目的な信頼を促すことには問題があると指摘しており、強力な技術に対しては、むしろユーザー側が積極的に懐疑心を持つことの方が健全であると論じています。

「信頼とは、それ自体がリスクを伴う行為である。信頼関係によって得られる利益が、信頼の破綻による不利益を上回るとは限らない。過度に信頼することは、常に軽率な行為である。だからこそ、特に強力な技術的人工物に関しては、不信が非常に重要になり得る。不信は、個人がリスクを無視せず、それをリスクとして認識し、適切に対応する状況を生み出す。したがって、『信頼できるAI(Trustworthy AI)』を目指すこと自体が、誤った目標である可能性がある。」

しかし、このような批判的な意識をどのように育むのでしょうか?ここで問題となるのは、規制や技術的な対策と比べて、具体的な実施方法が明確ではなく、やや抽象的に聞こえてしまう点です。現時点で私たちが活用できる手段は、公共向けのコンテンツを増やすこと、リテラシープログラムを実施すること、さらには公開討論を開催することくらいに限られています。しかし、個人がAI技術との関係を主体的に形成できるよう、より創造的なアプローチを模索する必要があります。例えば、AI倫理の専門家や研究者が、ストーリーテラー、映画監督、アーティストといった分野の人々と協力し、より魅力的なコンテンツや体験を生み出すことで、AIの倫理的な問題について一般の人々が理解し、考える機会を増やすことができるかもしれません。このようなコラボレーションは、複雑な倫理的議論をより具体的で身近なものにし、広く社会に浸透させる助けとなるでしょう。そして、私たちがまだ試みていないアプローチもきっと多く存在するはずです。

それでも、これは良い出発点です。「ボトムアップ」アプローチは、理想主義的あるいはエリート主義的だと批判されることが多いですが、三層モデルに基づくAI倫理の他の層を補完する役割を果たす点に価値があることを忘れてはなりません。個人層を単独では効果が薄い取り組みと捉えるのではなく、むしろ規制層を強化する要素として認識すべきです。内面的な倫理意識を備えた個人は、単なるガイドラインではカバーしきれない部分を補うことができます。これにより、規制層が設定するガードレールがより確実なものとなり、AI倫理全体の枠組みが強化されるのです。

意味を育む

DALでは、「還元主義への抵抗(単純化に抗う)」を提唱してきました。この概念は、複雑な議論を計算可能な形に単純化しようとすることの危険性を指摘するものです。その結果、実装は容易になるものの、概念的には浅薄になってしまいます。現在のAI倫理の実践は、まさにこの還元主義的傾向の典型的な例といえるでしょう。技術的な対策に偏重し、より深い倫理的考察を犠牲にしているのです。

倫理はプロセスとして追求すべきであり、技術的解決主義(technological solutionism)に陥ってはなりません。倫理とは、固定された目的地ではなく、継続的な熟慮の旅であることを認識することが重要です。育成される必要がある異なる層間の複雑な関係として見ることは、これらの複雑な時代をナビゲートするための有用な枠組みを提供します。特に、個人の倫理的関与の層には大きな可能性があると考え、今後多様なアプローチを探求し、試みていくことを目指しています。

Joseph Park is the Content Lead at DAL (joseph@dalab.xyz)

Illustration: Soryung Seo

Edits: Janine Liberty